Czy sztuczna inteligencja jest dla nas ludzi zagrożeniem? Jest, ale nie tak, jak myślisz.

Sztuczna inteligencja może pomóc w pracy i życiu, ale niesie też realne ryzyka: dezinformację, automatyzację manipulacji i oddawanie decyzji maszynom. Wyjaśniamy, gdzie leży problem i podajemy trzy proste zasady higieny AI na co dzień.

AI jest dla ludzi zagrożeniem, ale nie dlatego, że „zacznie nas nienawidzić” albo pewnego dnia się obudzi. Jest groźna, bo jest mnożnikiem: wzmacnia to, co w człowieku i w systemach już działa źle. A do tego robi to szybko, tanio i na masową skalę. Wystarczy, że przyspieszy to, co już dziś działa źle: plotkę, manipulację, pośpiech w decyzjach i nawyk delegowania odpowiedzialności. Najbardziej niepokojące w AI nie jest to, że potrafi myśleć — tylko że potrafi brzmieć, jakby myślała. A my, jako społeczeństwo, jesteśmy wyjątkowo podatni na autorytet formy.

1) Największe ryzyko: rozjechanie się prawdy z zasięgiem

Kiedy kłamstwo, manipulacja i „ładnie brzmiąca bzdura” stają się łatwiejsze do produkcji niż prawda do sprawdzenia, to przegrywa nie tylko dyskusja w internecie — przegrywa wspólna rzeczywistość.

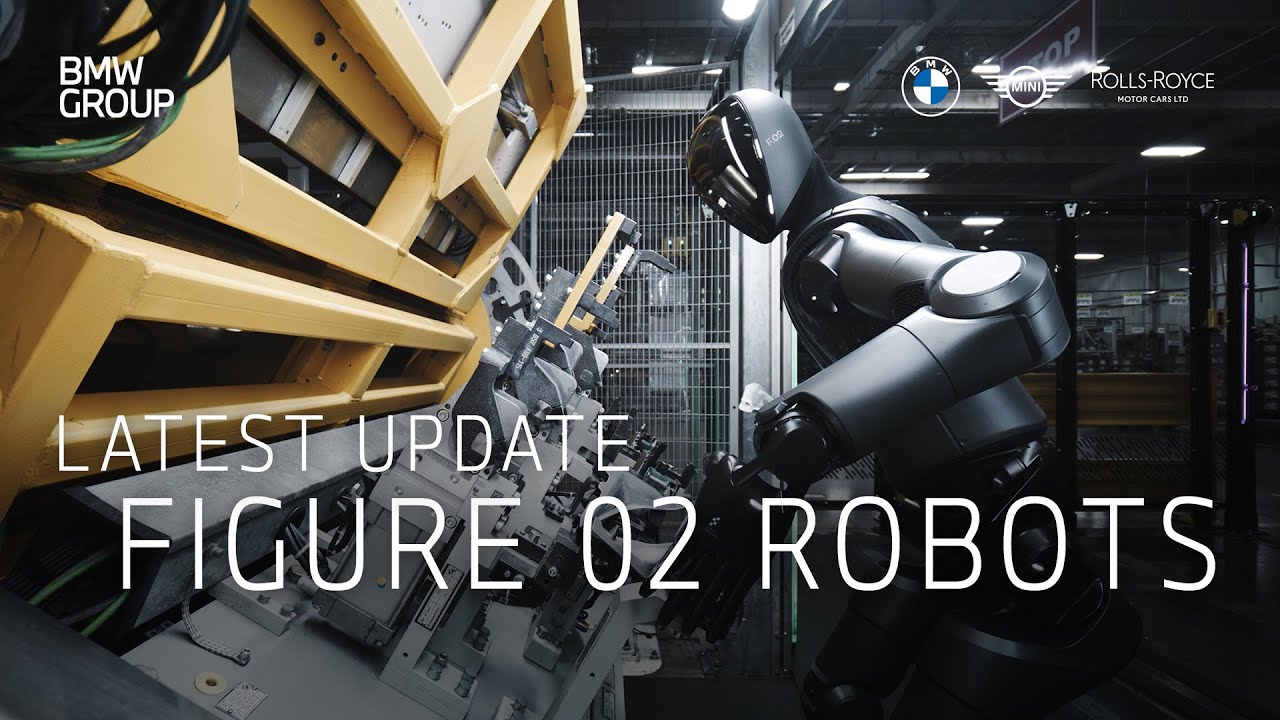

AI obniża koszt tworzenia przekonujących fikcji prawie do zera. To jest jak drukarnia plotek, która nie śpi. I to, naszym zdaniem będzie nas boleć bardziej niż roboty zabierające pracę.

2) Drugie ryzyko: oddawanie decyzji w ręce narzędzia, które „brzmi pewnie”

AI ma jedną zdradliwą cechę: potrafi mówić gładko, logicznie, w tonie eksperta — nawet gdy się myli. Ludzie są podatni na autorytet formy.

Jeśli zaczniemy traktować odpowiedzi modeli jako „wystarczająco dobre”, to w kluczowych miejscach (zdrowie, prawo, pieniądze, bezpieczeństwo) zrobi się niebezpiecznie, bo pomyłki staną się systemowe, a nie jednostkowe.

3) Trzecie ryzyko: uzależnienie od wygody

Nie chodzi o to, że AI „ogłupi” ludzi wprost. Bardziej o to, że zaczniemy delegować na nią:

-

pisanie,

-

planowanie,

-

podejmowanie decyzji,

-

myślenie po kolei.

I nagle okaże się, że umiemy mniej, mamy mniej cierpliwości do złożonych problemów, trudniej nam ocenić jakość informacji. To nie jest katastrofa jednego dnia — to powolna erozja kompetencji.

4) Czwarte ryzyko: koncentracja mocy

Najmocniejsze modele i infrastruktura są drogie. To sprzyja temu, że realną kontrolę mają nieliczni. A gdy w jednym miejscu kumuluje się wpływ na informację, pracę, reklamę, politykę, edukację i bezpieczeństwo — to nawet bez złej woli robi się niebezpiecznie.

5) Czy AI może być też wielką szansą?

Tak. I tu jest nasz „haczyk”: to jest narzędzie, które może nam podnieść poziom życia bardziej niż większość technologii ostatnich dekad, ale tylko wtedy, gdy będziemy je traktować jak prąd:

-

prąd jest genialny,

-

prąd zabija,

-

różnica to instalacja, bezpieczniki i nawyki.

Nasza konkluzja

AI jest zagrożeniem bardziej społecznym niż technicznym. Najgorsze scenariusze nie wyglądają jak wojna z robotami, tylko jak:

-

chaos informacyjny,

-

spadek zaufania,

-

automatyzacja manipulacji,

-

leniwe „odklepywanie” decyzji,

-

większa przewaga silnych nad słabymi.

I teraz najważniejsze: nie uważamy, że to jest nieuniknione. Ale uważamy, że domyślny kierunek, jeśli nic nie zrobimy (jako ludzie, firmy, państwa, użytkownicy), jest zły — bo optymalizuje się pod zasięg, szybkość i zysk, a nie pod prawdę i bezpieczeństwo.

Zasady higieny Ai

1) AI to asystent, nie świadek ani arbiter

Używaj AI do przyspieszania pracy (szkice, warianty, porządkowanie myśli), ale nie do „ustalania prawdy”. Gdy temat dotyczy zdrowia, prawa, pieniędzy, bezpieczeństwa albo czyjejś reputacji — AI może pomóc, ale ostatnie słowo zawsze musi mieć weryfikacja (dokument, oficjalne źródło, telefon do instytucji, druga osoba).

2) Zasada dwóch kanałów przy wszystkim, co „pilne” i emocjonalne

Jeśli dostajesz nagranie głosowe, film, screen albo wiadomość typu „działaj natychmiast” — zakładaj, że to może być manipulacja. Weryfikuj innym kanałem: oddzwaniasz, piszesz na znany numer, pytasz przez komunikator, którego ktoś normalnie używa. Nie dyskutujesz z treścią — sprawdzasz tożsamość i intencję.

3) Minimalizm danych: nie karm narzędzia tym, czego nie oddałbyś obcej osobie

Nie wrzucaj do AI danych wrażliwych (Twoich, firmy, klientów): PESEL/Steuer-ID, numery dokumentów, pełne umowy, adresy, medyczne szczegóły, hasła, treści „pod NDA”. Jeśli musisz — anonimizuj: zamieniaj dane na zmienne, skracaj, usuwaj identyfikatory. To jest najprostszy „bezpiecznik”, który działa zawsze.

Jakie jest Twoje zdanie?

Lubię

1

Lubię

1

Nie lubię

0

Nie lubię

0

Świetne

0

Świetne

0

Śmieszne

0

Śmieszne

0

Wnerwia

0

Wnerwia

0

Smutne

0

Smutne

0

Wow

0

Wow

0

![Obowiązek meldunkowy w Niemczech (2025): terminy, dokumenty, kary i rejestracja online [poradnik]](https://tygodnik.de/uploads/images/202509/image_140x98_68bafc82a5afc.webp)