Kiedy sztuczna inteligencja się myli – co naprawdę potrafią chatboty i dlaczego nie należy im ślepo ufać

Nowe badania pokazują, że nawet co trzecia odpowiedź chatbotów opartych na sztucznej inteligencji jest błędna lub zmyślona. Wyjaśniamy, czym są „halucynacje AI”, dlaczego ChatGPT potrafi wymyślać fakty i jak bezpiecznie korzystać z technologii, która zmienia świat.

Zaufanie do sztucznej inteligencji rośnie szybciej niż jej wiarygodność. Miliony osób w Niemczech każdego dnia proszą ChatGPT, Copilota czy Gemini o podsumowanie wiadomości, tłumaczenie faktów lub analizę wydarzeń. Ale nowy raport Europejskiej Unii Nadawców pokazuje coś niepokojącego: nawet co trzecia odpowiedź generowana przez chatboty jest po prostu… wymyślona.

Chatboty jako źródło informacji – wygoda z ryzykiem

Sztuczna inteligencja przestała być domeną programistów. Dziś używa jej niemal każdy: uczniowie piszą z pomocą ChatGPT szkolne wypracowania, pracownicy biurowi generują raporty w Microsoft Copilot, a tysiące ludzi pyta o bieżące wiadomości w Perplexity lub Gemini.

Dla wielu użytkowników chatbot stał się nowym „Googlem” — prostym i szybkim źródłem wiedzy. Problem w tym, że to źródło bywa bardzo zawodne. Według badań Europejskiej Unii Nadawców (EBU), zrzeszającej 68 publicznych stacji z 56 krajów, najpopularniejsze systemy oparte na sztucznej inteligencji generują błędy w 30–40% odpowiedzi, a niektóre wręcz podają fikcyjne źródła.

„Halucynacje” – czyli jak AI potrafi wymyślać fakty

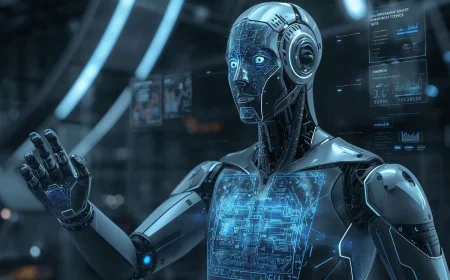

Eksperci z uczelni w Dortmundzie, którzy uczestniczyli w badaniach, tłumaczą zjawisko tak: chatboty nie rozumieją treści w ludzkim sensie. Nie weryfikują faktów, lecz statystycznie przewidują, jakie słowo powinno pojawić się po następnym. Jeśli w zbiorze danych znalazły się błędne lub nieprecyzyjne informacje, powielają je – często z dużym przekonaniem.

To właśnie dlatego ChatGPT potrafi błędnie „potwierdzić” nieaktualne fakty, Copilot myli skład NATO, a Gemini miesza chronologię wydarzeń politycznych. Takie sytuacje określa się mianem „halucynacji” (AI hallucinations) – fikcyjnych treści prezentowanych z pełnym autorytetem.

| Rodzaj błędu | Opis | Potencjalne skutki |

|---|---|---|

| Błąd faktograficzny | Podanie nieprawdziwej informacji jako faktu (np. mylne daty, nazwiska, liczby). | Wprowadzanie użytkowników w błąd, utrata wiarygodności. |

| Fałszywe źródło | Powoływanie się na nieistniejące lub błędne odniesienia (np. „Tagesschau napisała...”). | Utrata zaufania do mediów, szerzenie dezinformacji. |

| Halucynacja logiczna | Łączenie niepowiązanych faktów w sposób pozornie sensowny, ale całkowicie fałszywy. | Powstawanie wiarygodnych, lecz fałszywych narracji. |

Ryzyko dla społeczeństwa i demokracji

Niebezpieczeństwo nie tkwi jedynie w błędach technicznych, lecz w skali ich oddziaływania. Coraz więcej osób czerpie wiedzę o świecie bezpośrednio z chatbotów, rezygnując z tradycyjnych mediów.

Skutek? Fikcyjne informacje rozchodzą się po sieci błyskawicznie – użytkownicy udostępniają je w dobrej wierze, nie wiedząc, że mają do czynienia z wymysłem algorytmu.

Naukowcy ostrzegają: jeśli obywatele opierają decyzje polityczne lub wyborcze na niezweryfikowanych danych, zagrożone jest nie tylko zaufanie do mediów, lecz sama jakość debaty publicznej.

Uderzenie w wiarygodność mediów

To zjawisko uderza również w dziennikarstwo. Chatboty często „cytują” znane redakcje — ARD, ZDF, „FAZ”, „Süddeutsche Zeitung” — w kontekście, który nigdy nie miał miejsca.

Użytkownicy, nieświadomi, że cytat jest fikcyjny, zaczynają wątpić w prawdziwe źródła. Dla mediów publicznych to poważne wyzwanie – w dobie masowej automatyzacji granica między informacją a iluzją staje się coraz cieńsza.

Dlaczego AI się myli

Źródłem problemu nie jest „zła wola” maszyn, lecz sam sposób, w jaki zostały zaprogramowane. Systemy językowe, takie jak ChatGPT, Gemini czy Claude, nie mają dostępu do prawdziwego rozumienia świata – jedynie do statystycznych wzorców tekstów.

Ich „wiedza” to miliardy zdań z Internetu, posegregowane według prawdopodobieństwa, nie według prawdy.

Twórcy tych modeli próbują ograniczać błędy poprzez integrację z bazami danych, weryfikację źródeł czy tzw. „fact-checking” w czasie rzeczywistym. Ale nawet oni przyznają: halucynacje są problemem strukturalnym, którego nie da się całkowicie wyeliminować.

Jak bezpiecznie korzystać z chatbotów

EBU i organizacje medialne apelują o rozwagę. Chatboty mogą być znakomitym narzędziem do:

-

tworzenia tekstów,

-

streszczania długich dokumentów,

-

pisania kodu,

-

czy kreatywnej pracy językowej.

Nie nadają się jednak do:

-

ustalania faktów,

-

analiz politycznych,

-

informacji medycznych lub finansowych.

| Zastosowanie | Ryzyko błędów | Rekomendacja |

|---|---|---|

| Kreatywne pisanie, streszczenia | Niskie | Bezpieczne z kontrolą treści |

| Informacje polityczne, ekonomiczne | Wysokie | Zawsze weryfikować z mediami |

| Porady zdrowotne, finansowe | Bardzo wysokie | Nie stosować bez konsultacji z ekspertem |

Edukacja i odpowiedzialność – klucz do przyszłości

Specjaliści apelują, by edukacja medialna stała się obowiązkowym elementem nauczania w szkołach i na uczelniach.

Użytkownicy muszą wiedzieć, że AI to narzędzie, nie autorytet. A redakcje – że ich rolą nie jest konkurować z maszynami, lecz tłumaczyć świat, w którym fakty stają się coraz trudniejsze do odróżnienia od fikcji.

Jak podsumowuje jeden z ekspertów EBU:

„Chatbot może być błyskotliwy, ale nie jest mądry. Wciąż to człowiek musi wiedzieć, co jest prawdą.”

Chatboty to technologiczny przełom, który zmienia sposób, w jaki szukamy informacji. Ale też test dla naszej zdolności krytycznego myślenia. Dopóki sztuczna inteligencja nie zyska pełnej zdolności rozumienia kontekstu, błędy i halucynacje będą jej nieodłączną cechą.

Dlatego zanim uwierzymy w to, co napisała maszyna, warto zrobić to, co redaktorzy wciąż robią każdego dnia – sprawdzić źródło.

(Źródła: EBU, WDR, Verbraucherzentrale NRW, TU Dortmund, Tagesschau, ZDF, Süddeutsche Zeitung)

Jakie jest Twoje zdanie?

Lubię

0

Lubię

0

Nie lubię

0

Nie lubię

0

Świetne

0

Świetne

0

Śmieszne

0

Śmieszne

0

Wnerwia

0

Wnerwia

0

Smutne

0

Smutne

0

Wow

0

Wow

0